Искусственный интеллект и человеческий фактор

Искусственный интеллект, натренированный на больших данных, активно применяется в финансах для составления прогнозов – как по динамике всего рынка, так и по отдельным компаниям. Технологии машинного обучения позволяют получить более точные прогнозы будущих доходов компаний по сравнению с теми, которые делают аналитики, ведь их оценки искажаются из-за человеческого фактора, доказывают экономисты Джулс ван Бинсберген из Университета Пенсильвании, Алехандро Лопес-Лира из Норвежской школы менеджмента и Сяо Хань из Эдинбургского университета в недавно опубликованном исследовании.

Аналитики могут испытывать различные соблазны, которые влияют на точность их прогнозов: например, они могут делать прогнозы чрезмерно оптимистичными, чтобы снискать расположение руководства компании. Впрочем, само руководство тоже может быть заинтересовано в более позитивных прогнозах, поскольку они помогают привлечь больше средств инвесторов.

Бинсберген и соавторы сопоставили прошлые прогнозы аналитиков из базы данных Institutional Brokers’ Estimate System, которая охватывает свыше 20000 публичных компаний, с фактической динамикой доходов фирм. Они также разработали собственный алгоритм, который обучили делать аналогичные прогнозы на основе опубликованных прогнозов, а также открытых данных – финансовых показателей компаний за предыдущие годы и ряда макроэкономических показателей. Алгоритмы в своих прогнозах ошибаются меньше, чем аналитики, установили авторы.

Аналитики часто были слишком оптимистичны, но по мере приближения даты публикации отчетности понижали прогноз, делая его более точным (прогнозы обновляются ежемесячно): средняя ошибка прогноза прибыли на каждую акцию на конец текущего квартала снижалась с $0,025 во время первого прогноза до $0,014 в последнем прогнозе. Пересмотр в сторону понижения происходил также в прогнозах на два, три квартала и на год и два года вперед. Тогда как разница между прогнозом алгоритма и фактическими данными в среднем была близка к нулю, пишут исследователи.

Сопоставляя прогнозы аналитиков и алгоритма, разработанного авторами, можно рассчитать «цену предвзятости», пишут исследователи. Анализ экономистов показал, что акции, цена которых выросла на фоне оптимистичных прогнозов, принесут более низкую доходность по сравнению с теми ценными бумагами, в отношении которых аналитики не делали чрезмерно оптимистичных прогнозов.

Копирование ошибок

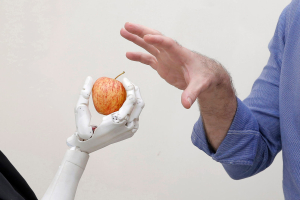

Искусственный интеллект используется не только для прогнозирования доходности компаний. В большинстве случаев модели, использующие машинное обучение, точнее предсказывают и вероятность кризисов.

Однако точности недостаточно, чтобы вызвать доверие, – важно понимание: машинные прогнозы часто представляют собой «черный ящик», куда поступают данные и откуда выходят решения, но даже сами разработчики алгоритма не знают, как именно и почему машина пришла к тому или иному выводу. Более того, машины могут «копировать» человеческие ошибки, закладывая их в алгоритмы, пишет редакция медицинского научного журнала The Lancet. И если ошибка человека обычно случайна, а ее последствия локальны, то ошибки систем искусственного интеллекта могут повторяться систематически, влиять на все центры, где эти системы используют, и такие ошибки сложно обнаружить.

Это показывают некоторые исследования, посвященные применению искусственного интеллекта в судебных решениях.

Джонатан Левав из Стэнфордского университета вместе с соавторами в своем знаменитом исследовании обнаружили, что на решение судьи влияет то, в какое время оно принимается: в самом начале дня решение об условно-досрочном освобождении могло быть положительным с вероятностью 65%, эта вероятность сокращалась ближе к обеду, после него снова возрастала и снова падала почти до нуля к началу очередного перерыва. Проще говоря, чем более голодным и уставшим был судья, тем с меньшей долей вероятности он принимал решение о досрочном освобождении. Позже Дэниел Чэнь (Тулузская школа экономики) и Джесс Игл (Нью-Йоркский университет) проанализировали около полумиллиона решений судей за более чем 30 лет о предоставлении убежища беженцам и обнаружили ту же закономерность, а разработанная ими модель искусственного интеллекта, обученная на массиве фактических данных, с высокой точностью – 82% – повторяла решения судей.

В 2016 г. издание ProPublica рассказало о том, что алгоритм COMPAS, который прогнозирует вероятности рецидива преступлений в США, предвзято относится к темнокожим. Исследование показало, что алгоритм почти в два раза чаще ошибочно присваивал высокий уровень риска темнокожим, а белых чаще, чем темнокожих, ошибочно относил к категории низкого риска. При этом, пишет издание, раса, национальность и цвет кожи не используются в криминологических прогнозах с 1970-х гг., когда это стало политически неприемлемым. Что стало причиной предвзятости алгоритма – неясно, поскольку компания-разработчик не раскрывает свои расчеты, используемые для оценки риска, а с выводами исследования не согласна.

В то же время алгоритм, обученный на закономерностях поведения обвиняемых, способен намного точнее предсказывать степень вероятности совершения повторного преступления, чем судьи, оценивающие такую вероятность для того, чтобы определить, будет ли обвиняемый ждать суда на свободе или в заключении (то есть может ли он скрыться или быть социально опасен). Исследование по США показало, что если бы решение принимала машина, то число преступлений, совершенных оставленными на свободе, снизилось бы на 14–25%, при этом алгоритм отправил бы под предварительное заключение только 42% от реального количества оказавшихся на время следствия в тюрьме.